Meta AI大洗牌!超级智能一拆四,小扎押注硅谷华人,LeCun或已出局

Meta AI大洗牌!超级智能一拆四,小扎押注硅谷华人,LeCun或已出局Meta在半年内第四次重组AI部门,将超级智能实验室拆分为四个团队,全面押注「超级智能」。新成立的TBD Lab由Alexandr Wang领衔,或放弃Llama 4并转向闭源模型,Meta开源旗帜动摇。Meta内部人心浮动,几家欢喜几家愁。

Meta在半年内第四次重组AI部门,将超级智能实验室拆分为四个团队,全面押注「超级智能」。新成立的TBD Lab由Alexandr Wang领衔,或放弃Llama 4并转向闭源模型,Meta开源旗帜动摇。Meta内部人心浮动,几家欢喜几家愁。

就在刚刚,Meta 宣布,清华校友赵晟佳(Shengjia Zhao)将正式担任其超级智能实验室( MSL)首席科学家。

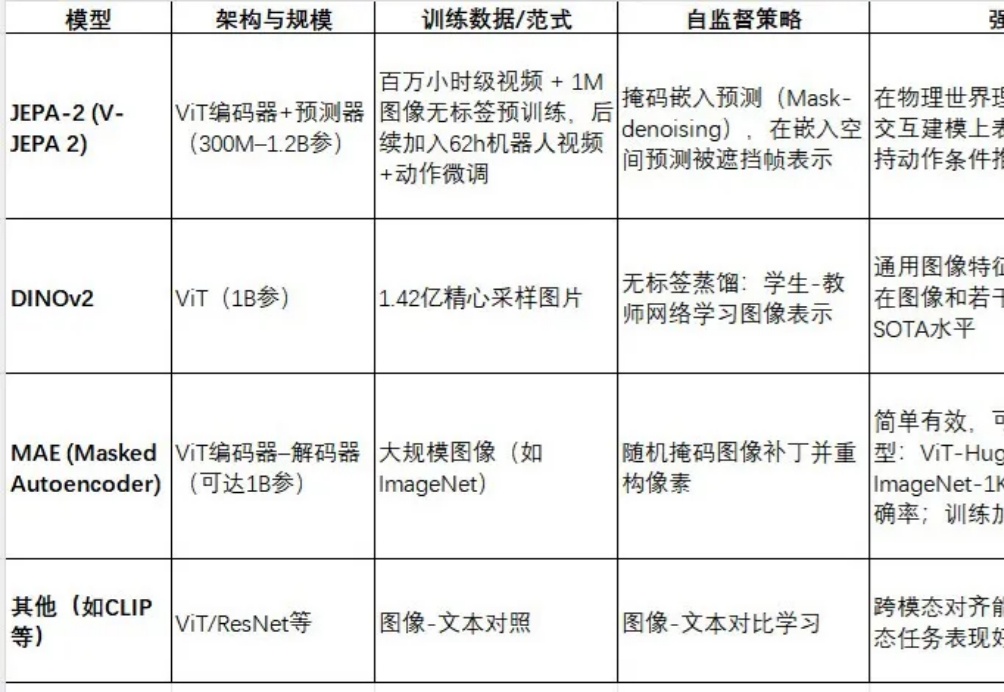

JEPA-2(V-JEPA 2)是Meta最新推出的视频世界模型,采用视图嵌入预测(Joint Embedding Predictive Architecture)框架进行自监督预训练。

近期,人工智能领域对“具身智能”的讨论持续升温——如何让AI不仅能“理解”语言,还能用“手”去感知世界、操作环境、完成任务?相比语言模型的迅猛发展,真正通向Agent的下一步,需要AI具备跨模态感知、动作控制与现实泛化能力。具身智能让AI不仅能“思考”,更能“感知”“行动”。

小扎亲手挖人,很疯狂。

就在刚刚,Meta 又有新的动作,推出基于视频训练的世界模型 V-JEPA 2(全称 Video Joint Embedding Predictive Architecture 2)。其能够实现最先进的环境理解与预测能力,并在新环境中完成零样本规划与机器人控制。

不仅是大模型本身,Meta 也要成为 AI 基建大厂。

付费订阅或许是一切AI助手的归宿,继OpenAI的ChatGPT、谷歌的Gemini,以及Anthropic的Cluade之后,Meta的AI助手Meta AI也准备提供付费订阅服务了。在日前举行的Meta年度股东大会上,扎克伯格除了确认Meta AI已实现10亿月活跃用户的成绩之余,还宣称“随着Meta AI不断改进,未来也将有机会推出付费推荐或额外算力使用的订阅服务。”

面对谷歌、OpenAI等劲敌猛攻及Llama 4翻车、人才流失困境,小扎决定重组Meta GenAI团队,设AI产品、AGI基础和FAIR三大架构。

今天,在首届LlamaCon开发者大会上,Meta正式发布了对标ChatGPT的智能助手Meta AI App,并宣布面向开发者提供官方Llama API服务的预览版本。Meta AI App是一款智能助手,基于Llama模型打造,可通过社交媒体账号了解用户偏好、记住上下文。与ChatGPT一样,Meta AI App支持语音和文本交互,并额外支持了全双工语音交互(Full-duplex,